Path: blob/master/site/es-419/addons/tutorials/layers_weightnormalization.ipynb

38500 views

Copyright 2020 The TensorFlow Authors.

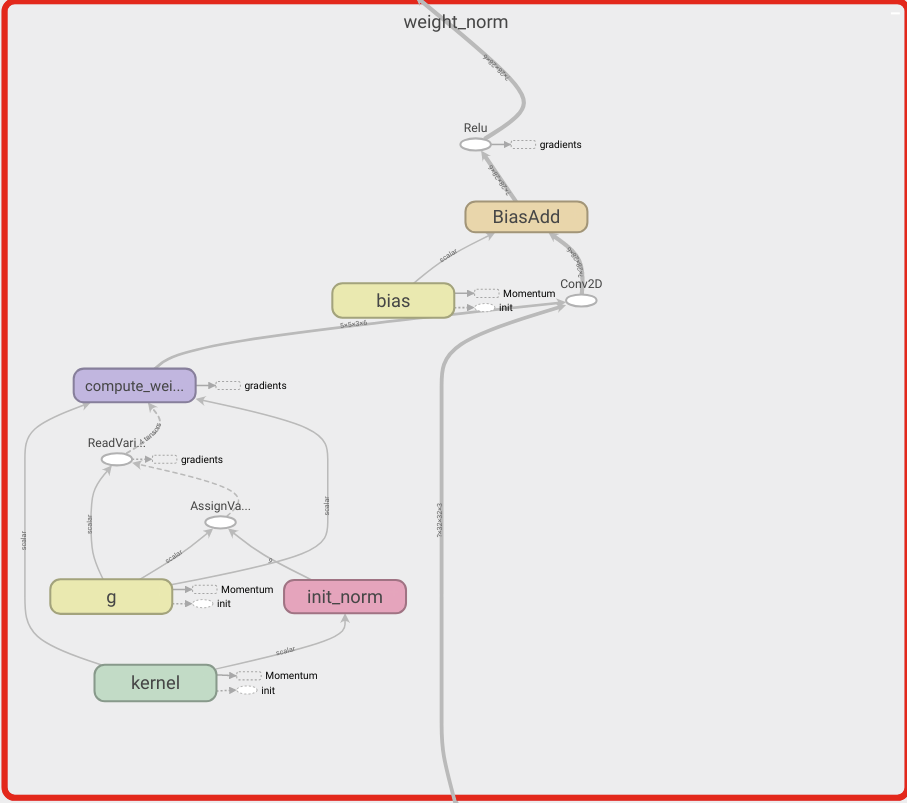

Capas de componentes de TensorFlow: Normalización por peso

Descripción general

En estas notas se demuestra cómo usar la capa de normalización por peso y de qué manera esta acción mejora la convergencia.

Normalización por peso

Es una reparametrización simple para acelerar el entrenamiento de redes neuronales profundas:

Tim Salimans, Diederik P. Kingma (2016)

Mediante la reparametrización de los pesos se mejora el condicionamiento del problema de optimización y se acelera la convergencia del descenso de gradientes estocásticos. Nuestra reparametrización se inspira en la normalización por lotes, pero no introduce ninguna dependencia entre los ejemplos de un minilote. Significa que nuestro método también se puede aplicar con éxito en modelos recurrentes como los LSTM y en aplicaciones sensibles al ruido, como los modelos generativos o de aprendizaje de refuerzo profundo, para los que la normalización es menos adecuada. A pesar de que nuestro método es mucho más simple, aún aporta gran parte de la aceleración para la normalización de lotes enteros. Además, el sobrecoste computacional de nuestro método es más bajo; por lo tanto, permite contar con más pasos de optimización en la misma cantidad de tiempo.

Ver en TensorFlow.org

Ver en TensorFlow.org Ejecutar en Google Colab

Ejecutar en Google Colab Ver fuente en GitHub

Ver fuente en GitHub Descargar bloc de notas

Descargar bloc de notas