Path: blob/master/site/ja/addons/tutorials/layers_weightnormalization.ipynb

38313 views

Kernel: Python 3

Copyright 2020 The TensorFlow Authors.

In [ ]:

概要

このノートブックでは、重み正規化レイヤーの使用方法と収束性を向上させる方法を説明します。

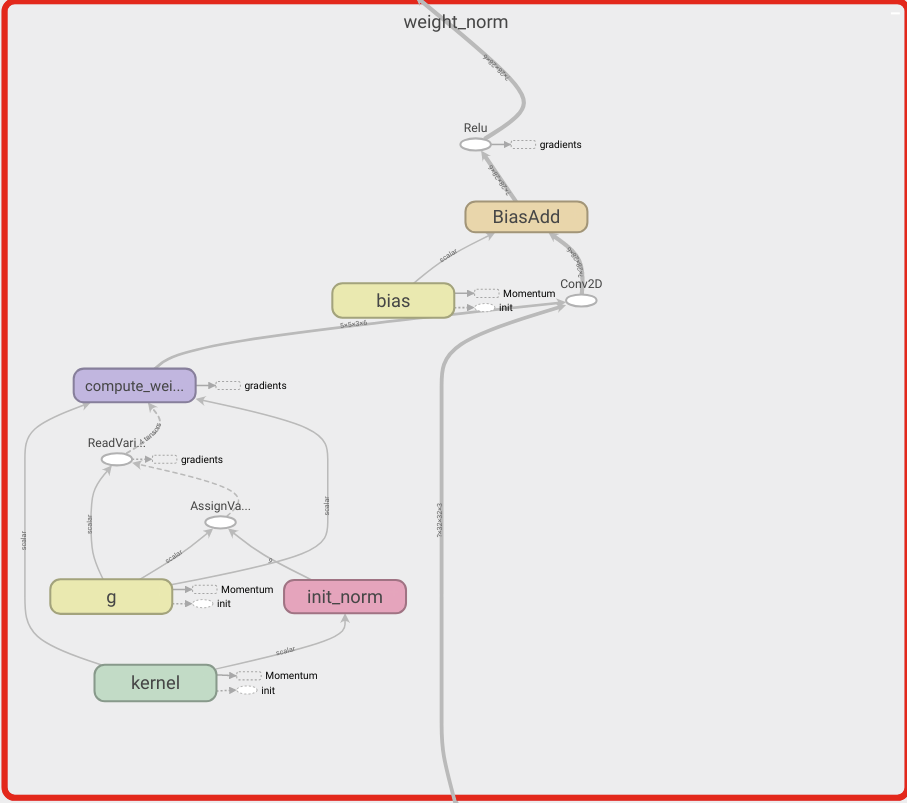

重み正規化

ディープニューラルネットワークのトレーニングを高速化する単純な再パラメータ化である。

Tim Salimans、Diederik P. Kingma(2016)

この方法で重みを再パラメータ化することにより、最適化問題の条件付けを改善し、確率的勾配降下法の収束を高速化します。我々の再パラメータ化はバッチ正規化から着想を得ていますが、ミニバッチ内で例と例の間の依存性は導入していません。つまり、この手法は LSTM のような再帰モデルや、深層強化学習や生成モデルのようなバッチ正規化があまり適していないノイズに敏感なアプリケーションにもうまく適用できることを意味します。この手法ははるかに単純ではありますが、完全なバッチ正規化の高速化の大部分を提供します。さらに、我々の手法の計算オーバーヘッドは低くなるため、同じ時間内により多くの最適化ステップを実行することができます。

MNIST モデルをビルドする

In [ ]:

In [ ]:

In [ ]:

In [ ]:

モデルを構築する

In [ ]:

In [ ]:

データを読み込む

In [ ]:

モデルをトレーニングする

In [ ]:

In [ ]:

In [ ]:

TensorFlow.org で表示

TensorFlow.org で表示 Google Colab で実行

Google Colab で実行 GitHub でソースを表示

GitHub でソースを表示 ノートブックをダウンロード

ノートブックをダウンロード