Path: blob/master/site/ja/guide/ragged_tensor.ipynb

38541 views

Copyright 2018 The TensorFlow Authors.

APIドキュメント: tf.RaggedTensor tf.ragged

セットアップ

概要

データにはさまざまな形状があります。テンソルも同じです。不規則なテンソルは、TensorFlow 相当のネストされた可変長リストです。このテンソルを使用すると、次のような不均一な形状のデータを簡単に保存して処理できます。

映画の俳優のセットなど、可変長の特徴量。

テキストや動画クリップなど、可変長シーケンシャル入力のバッチ。

セクション、段落、文、単語に細分されたテキストドキュメントなどの階層的な入力。

プロトコルバッファなどの構造化入力の個々のフィールド。

不規則なテンソルを使用してできること

不規則なテンソルは、100 個以上の TensorFlow 演算(tf.add や tf.reduce_mean など)、配列演算(tf.concat や tf.tile など)、文字列操作演算(tf.substr など)、制御フロー演算(tf.while_loop や tf.map_fn など)、およびその他多数の演算でサポートされています。

ファクトリメソッド、変換メソッド、および値のマッピング演算など、不規則なテンソルに固有のメソッドや演算も多数あります。サポートされている演算のリストについては、tf.ragged パッケージドキュメントをご覧ください。

不規則なテンソルは、Keras、Datasets、tf.function、SavedModels、および tf.Example など、多数の TensorFlow API でサポートされています。詳細については、以下の「TensorFlow API」のセクションをご覧ください。

通常のテンソルと同様に、Python スタイルのインデキシングを使用して、不規則なテンソルの特定のスライスにアクセスできます。詳細については、以下の「インデキシング」のセクションをご覧ください。

また、通常のテンソルと同様に、Python の算術演算子と比較演算子を使用して、要素ごとの演算を実行できます。詳細については、以下の「オーバーロードされた演算子」をご覧ください。

RaggedTensor の値に要素ごとの変換を実行する必要がある場合は、 tf.ragged.map_flat_values を使用できます。これは、関数と 1 つ以上の引数をとり、関数を適用して RaggedTensor の値を変換します。

不規則なテンソルは、ネストされた Python list と NumPy の array に変換できます。

不規則なテンソルを構築する

不規則なテンソルを構築するには、tf.ragged.constant を使用するのが最も簡単な方法です。これは、特定のネストされた Python list または NumPy の array に応じた RaggedTensor を構築します。

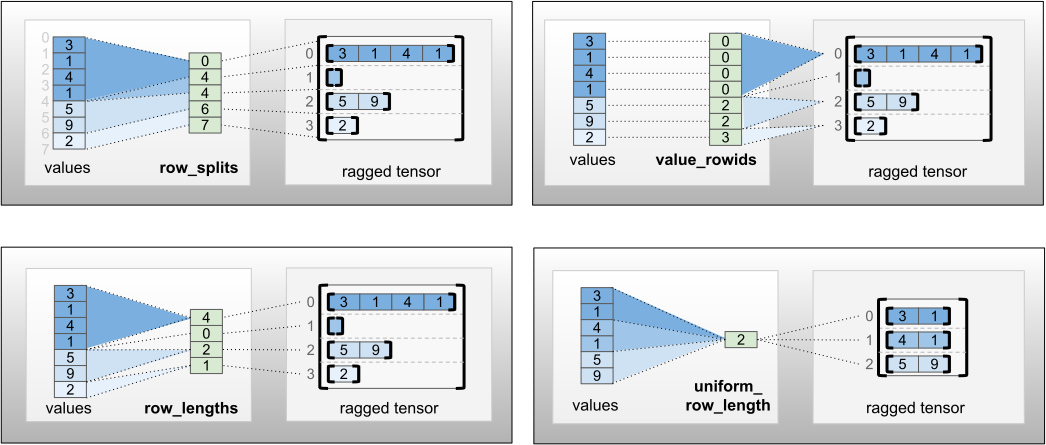

不規則なテンソルは、フラット値のテンソルと行を分割するテンソルを組み合わせ、tf.RaggedTensor.from_value_rowids、tf.RaggedTensor.from_row_lengths、および tf.RaggedTensor.from_row_splits などのファクトリクラスメソッドを使ってこれらの値をどのように行に分割するのかを示すことで、構築することもできます。

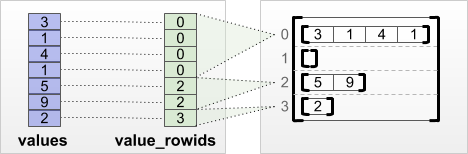

tf.RaggedTensor.from_value_rowids

各値が属する行がわかっている場合は、value_rowids 行分割テンソルを使用して、RaggedTensor を構築できます。

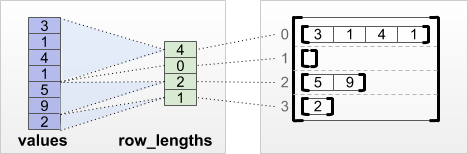

tf.RaggedTensor.from_row_lengths

各行の長さがわかっている場合は、row_lengths 行分割テンソルを使用できます。

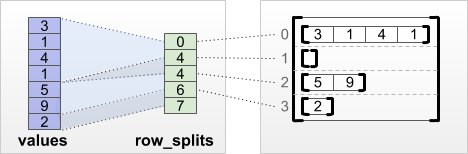

tf.RaggedTensor.from_row_splits

各行が開始および終了するインデックスがわかっている場合は、row_splits 行分割テンソルを使用できます。

ファクトリメソッドの全リストについては、tf.RaggedTensor クラスのドキュメントをご覧ください。

注意: デフォルトでは、これらのファクトリメソッドによって、行分割テンソルが整形されており、値の数と一貫しているというアサーションが追加されます。入力の整形と一貫性を保証できる場合は、validate=False パラメータを使用してこれらの検査を省略できます。

不規則なテンソルに格納できるもの

通常の Tensor と同様に、RaggedTensor の値にはすべて同じ型が必要で、値にはすべて同じネストの深度(テンソルの階数)が必要です。

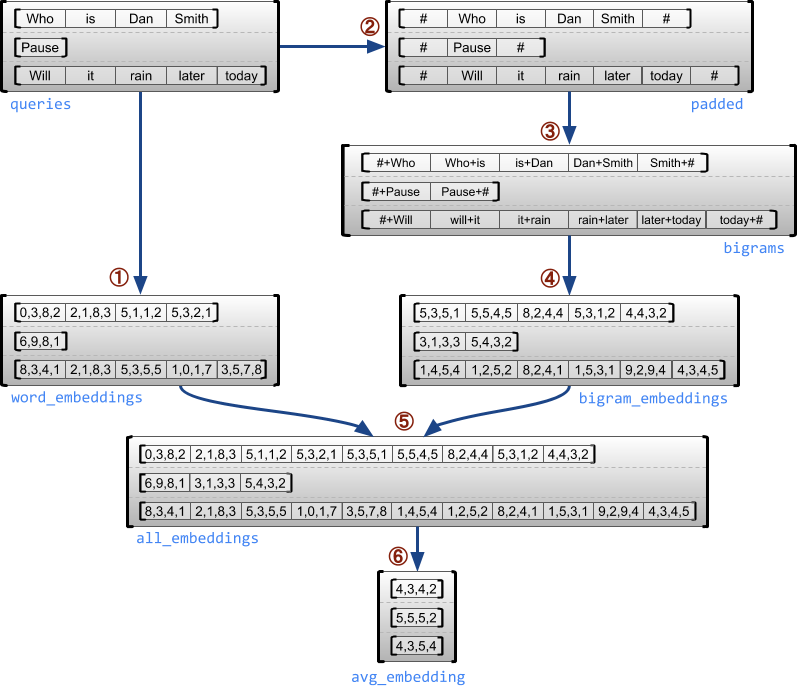

使用事例

次の例は、各文の最初と最後に特殊マーカーを使用して、可変長クエリのバッチのユニグラムとバイグラムの埋め込みを構築して組み合わせるために RaggedTensor を使用する方法を示しています。この例で使用されている演算に関する詳細は、tf.ragged パッケージドキュメントをご覧ください。

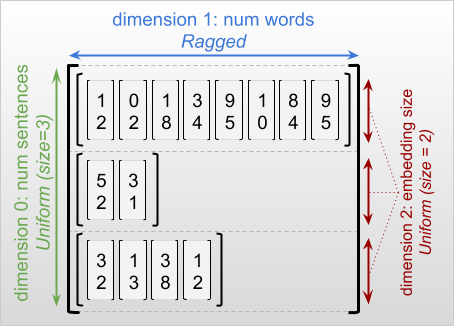

不規則な次元と一様次元

不規則な次元とは、スライスの長さが異なる次元を指します。たとえば、内側の(列の)次元 rt=[[3, 1, 4, 1], [], [5, 9, 2], [6], []] は不規則です。これは、列スライス(rt[0, :], ..., rt[4, :])の長さが異なるからです。スライスの長さがすべて同一の次元は一様次元と呼ばれます。

不規則なテンソルの一番外側の次元は、必ず一様です。これは、単一のスライスで構成されているためです(単一であるため長さが異なることがない)。残りの次元は、不規則または一様です。たとえば、形状 [num_sentences, (num_words), embedding_size]((num_words) の括弧は次元が不規則であることを示す)の不規則な次元を使用して、文のバッチの各語に対する語の埋め込みを格納することができます。

不規則なテンソルは、複数の不規則な次元を持つことができます。たとえば、形状 [num_documents, (num_paragraphs), (num_sentences), (num_words)](括弧は不規則な次元であることを示す)のテンソルを使用して、構造化テキストドキュメントのバッチを格納できます。

tf.Tensor と同様に、不規則なテンソルの階数は、次元の合計数(不規則な次元と一様次元の両方を含む)です。潜在的に不規則なテンソル は、tf.Tensor または tf.RaggedTensor のいずれかである値です。

RaggedTensor の形状を記述する場合、不規則な次元は従来、それを丸括弧で囲むことで示されます。たとえば、上記の例で示したように、文のバッチの各語に対する語の埋め込みを格納する 3-D RaggedTensor の形は、[num_sentences, (num_words), embedding_size] と記述できます。

RaggedTensor.shape 属性は、不規則なテンソルの tf.TensorShape を返します。不規則な次元のサイズは None です。

メソッド tf.RaggedTensor.bounding_shape は、指定された RaggedTensor の密着する境界形状を見つけるために使用できます。

不規則とスパース

不規則なテンソルをスパーステンソルの一種として捉えてはいけません。具体的には、スパーステンソルは、tf.Tensor の効率的なエンコーディングで、同一のデータをコンパクトな形式でモデルする一方、不規則なテンソルは tf.Tensor の拡張で、データの拡張クラスをモデルします。演算を定義する場合に、この違いが非常に重要となります。

スパーステンソルまたは密なテンソルに演算を適用すると、同じ結果を得られます。

不規則なテンソルまたはスパーステンソルに演算を適用すると、異なる結果が得られる場合があります。

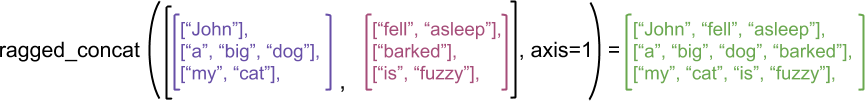

実例として、concat、stack、および tile などの配列演算が不規則なテンソルとスパーステンソルにどのように定義されているか考察してみましょう。不規則なテンソルを連結すると、各行が結合されて、長さが組み合わされた単一の行が形成されます。

ところが、次の例で説明されているように、スパーステンソルを連結すると、対応する密のテンソルと同じ結果が得られます(Ø は欠落した値)。

この区別が重要であることを示すもう 1 つの例として、tf.reduce_mean などの演算の「各行の平均値」の定義を考察してみましょう。不規則なテンソルでは、行の平均値は、行の値の合計を行の幅で除算した値となりますが、スパーステンソルでは、行の平均値は、行の値の合計をスパーステンソルの全体的な幅(最長行の幅以上になる)で除算した値となります。

TensorFlow API

Keras

tf.keras は、ディープラーニングモデルの構築とトレーニングに使用する TensorFlow の高位 API です。不規則なテンソルは、tf.keras.Input または tf.keras.layers.InputLayer に ragged=True を設定することで、Keras モデルに入力として渡すことができます。また、Keras レイヤー間で渡して、Keras モデルによって返すことも可能です。次の例は、不規則なテンソルを使用してトレーニングされる LSTM トイモデルを示します。

tf.Example

tf.Example は、TensorFlow データの標準的な protobuf エンコーディングです。tf.Example でエンコードされるデータには通常、可変長の特徴量が含まれます。たとえば、次のコードは、異なる特徴の長さを持つ 4 つの tf.Example メッセージのバッチを定義しています。

このエンコードされたデータは、tf.io.parse_example を使用して解析できます。シリアル化文字列のテンソルと特徴の仕様を表すディクショナリを取り、ディクショナリのマッピング特徴名をテンソルに返します。不規則なテンソルに可変長の特徴を読み取るには、特徴仕様ディクショナリで tf.io.RaggedFeature を使用します。

複数の不規則な次元を持つ特徴を読み取るには、tf.io.RaggedFeature も使用できます。詳細については、API ドキュメントをご覧ください。

データセット

tf.data は、単純で再利用可能なピースから複雑な入力パイプラインを構築できる API です。そのコアデータ構造は tf.data.Dataset で、一連の要素を表し、その各要素には 1 つ以上のコンポーネントが含まれます。

不規則なテンソルを伴うデータセットを構築する

データセットは、tf.Tensor または NumPy の array から構築する際に使用されるのと同じメソッド、つまり Dataset.from_tensor_slices を使用して、不規則なテンソルから構築できます。

注意: Dataset.from_generator は不規則なテンソルにまだ対応していませんが、近々サポートされる予定です。

不規則なテンソルを伴うデータセットをバッチ処理またはバッチ解除する

不規則なテンソルを伴うデータセットは、Dataset.batch メソッドを使用してバッチ処理できます(n 個の連続した要素を単一の要素に組み合わせます)。

逆に、バッチ処理されたデータセットは、Dataset.unbatch を使用して、フラットデータセットに変換できます。

可変長の非不規則テンソルを伴うデータセットをバッチ処理する

非不規則テンソルを含むデータセットで、テンソルの長さが要素間で異なる場合は、dense_to_ragged_batch 変換を使用して、それらの非不規則テンソルを不規則なテンソルにバッチ処理できます。

不規則なテンソルを伴うデータセットを変換する

また、Dataset.map を使って、データセットの不規則なテンソルを作成または変換することができます。

tf.function

tf.function は、Python 関数向けに TensorFlow グラフを事前計算するデコレータで、TensorFlow コードのパフォーマンスを大幅に改善できます。不規則なテンソルは、@tf.function でデコレートされた関数と透過的に使用することができます。たとえば、次の関数は、不規則なテンソルと非不規則テンソルの両方で動作します。

tf.function で input_signature を明示的に指定する場合は、tf.RaggedTensorSpec を使用して行います。

具象関数

具象関数は、tf.function で構築された個別のトレース済みグラフをカプセル化します。不規則なテンソルは、具象関数と透過的に使用できます。

SavedModel

SavedModel は、シリアル化された TensorFlow プログラムで、重みと計算の両方が含まれます。Keras モデルまたはカスタムモデルから構築することができますが、いずれの場合でも、不規則なテンソルは SavedModel によって定義された関数とメソッドを使って、透過的に使用することができます。

例: Keras モデルを保存する

例: カスタムモデルを保存する

注意: SavedModel シグネチャは具象関数です。上記の「具象関数」のセクションで説明したとおり、具象関数による不規則なテンソルの処理は、TensorFlow 2.3 以降でのみ正しく行われます。TensorFlow の旧バージョンで SavedModel シグネチャを使用する必要がある場合は、不規則なテンソルをコンポーネントテンソルに分解することをお勧めします。

オーバーロードされた演算

RaggedTensor クラスは標準的な Python 算術と比較演算をオーバーロードするため、基本的な要素ごとの計算が簡単に行えるようになります。

オーバーロードされた演算は、要素ごとの計算を実行するため、すべての二項演算への入力が同じ形状であるか、同じ形状にブロードキャスト可能である必要があります。最も単純なブロードキャストの場合、単一のスカラーは、不規則なテンソルの各値と要素ごとに組み合わされます。

より高度な事例については、ブロードキャストに関するセクションをご覧ください。

不規則なテンソルは、通常の Tensor と同じ一連の演算子をオーバーロードします。それらは、単項演算子の -、~、および abs()、二項演算子の +、-、*、/、//、%、**、&、|、^、==、<、<=、>、および >= です。

インデキシング

不規則なテンソルは、多次元のインデキシングとスライシングを含む、Python 形式のインデキシングをサポートしています。次の例では、2D と 3D の不規則なテンソルによる不規則なテンソルのインデキシングを示しています。

インデキシングの例: 2D 不規則テンソル

インデキシングの例: 3D 不規則テンソル

RaggedTensor は多次元のインデキシングとスライシングをサポートしていますが、1 つだけ制限があります。それは、不規則な次元へのインデキシングはできないということです。示された値が一部の行のみに存在することがあるため、これは悩ましいことです。このような場合は、(1)IndexError を発するべきか、(2)デフォルト値を使用すべきか、(3)その値をスキップして、開始した数より少ない行数のテンソルを返すべきか、明確ではありません。Python の基本原則(「曖昧なものに出逢ったら、その意味を適当に推測してはいけない。」)に則り、現在のところこの演算を許可していません。

テンソル型の変換

RaggedTensor クラスは、RaggedTensor と tf.Tensor または tf.SparseTensors 間の変換に使用できるメソッドを定義します。

不規則なテンソルの評価

不規則なテンソルの値にアクセスするには、次を行えます。

tf.RaggedTensor.to_listを使用して、不規則なテンソルをネストされた Python リストに変換する。tf.RaggedTensor.numpyを使用して、不規則なテンソルを NumPy 配列にネストされた値を持つ NumPy 配列に変換する。tf.RaggedTensor.valuesとtf.RaggedTensor.row_splitsプロパティ、またはtf.RaggedTensor.row_lengthsやtf.RaggedTensor.value_rowidsなどの行分割メソッドを使用して、不規則なテンソルをコンポーネントに分解する。Python インデキシングを使用して、不規則なテンソルから値を選択する。

不規則な形状

テンソルの形状は、各軸のサイズを指定します。たとえば、[[1, 2], [3, 4], [5, 6]] の形状は [3, 2](3 行と 2 列)です。TensorFlow には、形状を記述する 2 つの別個の関連する方法があります。

静的形状: 静的にわかっている軸サイズに関する情報(例:

tf.functionのトレース時)。部分的に指定することができます。動的形状: 軸のサイズに関するランタイム情報。

静的形状

Tensor の静的形状には、グラフ構築時に知られている軸サイズに関する情報が含まれています。tf.Tensor と tf.RaggedTensor の両方で、.shape プロパティを使用して利用でき、tf.TensorShape を使用してエンコードされます。

不規則なサイズの静的形状は常に None(つまり、未指定)です。ただし、逆は真ではありません。TensorShape 次元が None の場合、次元が不規則、または、次元が均一であるが、そのサイズが静的にわかっていないことを示します。

動的形状

テンソルの動的形状には、グラフの実行時に認識される軸サイズに関する情報が含まれています。これは、tf.shape 演算を使用して構築されます。tf.Tensor の場合、tf.shape は形状を 1D 整数 Tensor として返します。ここで tf.shape(x)[i ] は軸 i のサイズです。

ただし、1次元 Tensor は、tf.RaggedTensor の形状を記述するほど表現力がありません。代わりに、不規則なテンソルの動的形状は、専用の形状tf.experimental.DynamicRaggedShape を使用してエンコードされます。 次の例では、tf.shape(rt) によって返される DynamicRaggedShape は、不規則なテンソルが長さ 1、3、0、2 の 4 つの行を持っていることを示しています。

動的形状: 演算

DynamicRaggedShape は、tf.reshape、tf.zeros、tf.ones、tf.fill、tf.broadcast_dynamic_shape、tf.broadcast_to など、形状を想定するほとんどの TensorFlow の演算で使用できます。

動的形状: インデキシングとスライス

DynamicRaggedShape は、均一な次元のサイズを取得するためにインデックスを付けることもできます。たとえば、tf.shape(rt)[0] を使用して不規則テンソルの行数を見つけることができます(非不規則テンソルの場合と同様)。

ただし、インデキシングを使用して不規則な次元のサイズを取得しようとするとエラーになります。これは、サイズが 1 つでないためです。(RaggedTensor は不規則な軸を追跡するため、このエラーは eager 実行時または tf.function をトレースするときにのみスローされます。具体的な 関数の実行時にはスローされません。)

また、DynamicRaggedShape は、スライスが軸 0 で始まるか、密な次元のみを含む限り、スライスできます。

動的形状: エンコーディング

DynamicRaggedShape 次の 2 つのフィールドを使用してエンコードされます。

inner_shape: 密なtf.Tensorの形状を与える整数ベクトル。row_partitions:tf.experimental.RowPartitionオブジェクトのリストで、不規則な軸を追加するために内部形状の最も外側の次元を分割する方法を記述します。

行パーティションの詳細については、以下の「RaggedTensor エンコーディング」セクションと tf.experimental.RowPartition の API ドキュメントを参照してください。

動的形状: 構築

DynamicRaggedShape は、ほとんどの場合、{code 1}tf.shape を RaggedTensor に適用することによって構築されますが、直接構築することもできます。

すべての行の長さが静的に知られている場合は、DynamicRaggedShape.from_lengths を使用して動的な不規則な形状を構築することもできます。(不規則な次元の長さが静的に知られることはほとんどありませんが、これはテストおよびデモンストレーションコードに役立ちます)。

ブロードキャスト

ブロードキャストとは、さまざまな形状のテンソルに要素単位の演算で互換性のある形状を持たせるプロセスです。ブロードキャストの詳しい背景については、次をご覧ください。

tf.broadcast_dynamic_shapetf.broadcast_to

次は、互換性のある形状を持たせるために x と y の 2 つの入力をブロードキャストする基本手順です。

xとyの次元数が異なる場合は、次元数が同じになるまで外側の次元(サイズ 1)を追加します。xとyのサイズが異なる各次元に対し、次のことを行います。

xまたはyの次元dがサイズ1の場合は、もう片方の入力のサイズに一致するように、次元dでその値を繰り返します。そうでない場合は、例外(

xとyはブロードキャスト互換ではない)を発します。

一様次元内のテンソルのサイズは単一の数字であり(その次元のスライスのサイズ)、不規則な次元内のテンソルサイズはスライスの長さのリスト(その次元のすべてのスライス)です。

ブロードキャストの例

次は、ブロードキャストしない形状の例です。

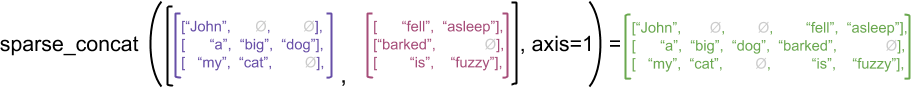

RaggedTensor エンコーディング

不規則なテンソルは、RaggedTensor クラスを使ってエンコードされています。内部的に、各 RaggedTensor は次の項目で構成されています。

valuesテンソル。可変長の行をフラットリストに連結します。row_partition。フラット化された値がどのように行に分割されているかを示します。

row_partition は、次の 4 つのエンコーディングで保存できます。

row_splitsは、行間の分割ポイントを指定する整数ベクトルです。value_rowidsは、各値の行インデックスを指定する整数ベクトルです。row_lengthsは、各行の長さを指定する整数ベクトルです。uniform_row_lengthは、すべての行の単一の長さを指定する整数スカラーです。

整数スカラー nrows は、valuerowids のある空の後続の行、または uniform_row_length のある空の行を構成するように、row_partition エンコーディングに含めることができます。

行分割に使用するエンコーディングの選択は、不規則なテンソルによって内部的に管理されており、一部の文脈で効率性を改善することができます。具体的には、異なる行分割スキームのメリットと欠点には次のようなものがあります。

効率的なインデキシング:

row_splitsエンコーディングにより、不規則なテンソルへの一定時間のインデキシングとスライシングが可能になります。効率的な連結:

row_lengthsエンコーディングは、不規則なテンソルを連結する場合により効率性が高くなります。2 つのテンソルを連結する際に、行の長さが変化しないためです。小さなエンコーディングサイズ:

value_rowidsエンコーディングは、空の行が大量にある不規則なテンソルを格納する際により効率性が高くなります。テンソルのサイズが、値の合計数にのみ依存しているためです。一方、row_splitsとrow_lengthsエンコーディングは、より長い行のある不規則なテンソルを格納する際により効率性が高くなります。各行に必要なスカラー値が 1 つのみであるためです。互換性:

value_rowidsスキームは、演算で使用されるセグメンテーション形式に一致しています(tf.segment_sumなどの演算)。row_limitsスキームは、tf.sequence_mask演算で使用される形式に一致しています。一様次元: 以下で説明するように、一様次元を伴う不規則なテンソルのエンコードには、

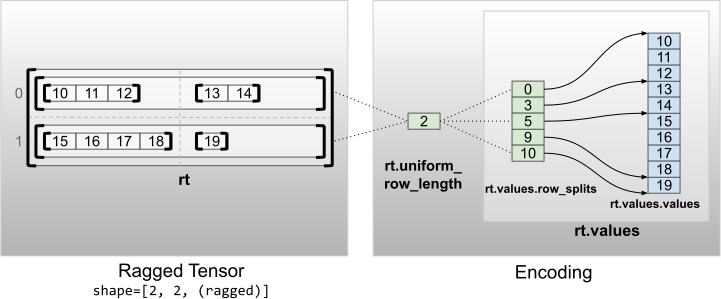

uniform_row_lengthエンコーディングが使用されます。

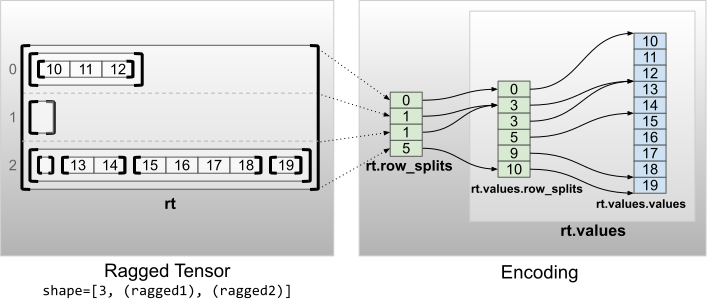

複数の不規則な次元

複数の不規則な次元を伴う不規則なテンソルは、values テンソルにネストされた RaggedTensor を使用することで、エンコードされます。それぞれのネストされた RaggedTensor は、単一の不規則な次元を追加します。

ファクトリ関数 tf.RaggedTensor.from_nested_row_splits は、row_splits テンソルのリストを提供することで、複数の不規則な次元を持つ RaggedTensor を直接構築するために使用できます。

不規則な階数とフラット値

不規則なテンソルの不規則な階数は、Tensor が持つ基底の values が何回分割されたかを表す数字です(RaggedTensor オブジェクトのネスト深度)。最も内側の values テンソルは flat_values と呼ばれます。次の例では、conversations には ragged_rank=3 があり、flat_values は 24 個の文字列を持つ 1D Tensor です。

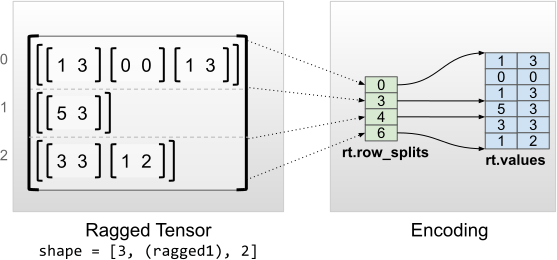

一様の内部次元

一様の内部次元を伴う不規則なテンソルは、flat_values(最内部の values)に多次元の tf.Tensor を使用することでエンコードされます。

一様の非内部次元

一様の非内部次元を伴う不規則なテンソルは、uniform_row_length で行を分割してエンコードします。

TensorFlow.org で表示

TensorFlow.org で表示 Google Colab で実行

Google Colab で実行 GitHubでソースを表示

GitHubでソースを表示 ノートブックをダウンロード

ノートブックをダウンロード