Path: blob/master/site/ko/addons/tutorials/layers_weightnormalization.ipynb

38312 views

Kernel: Python 3

Copyright 2020 The TensorFlow Authors.

In [ ]:

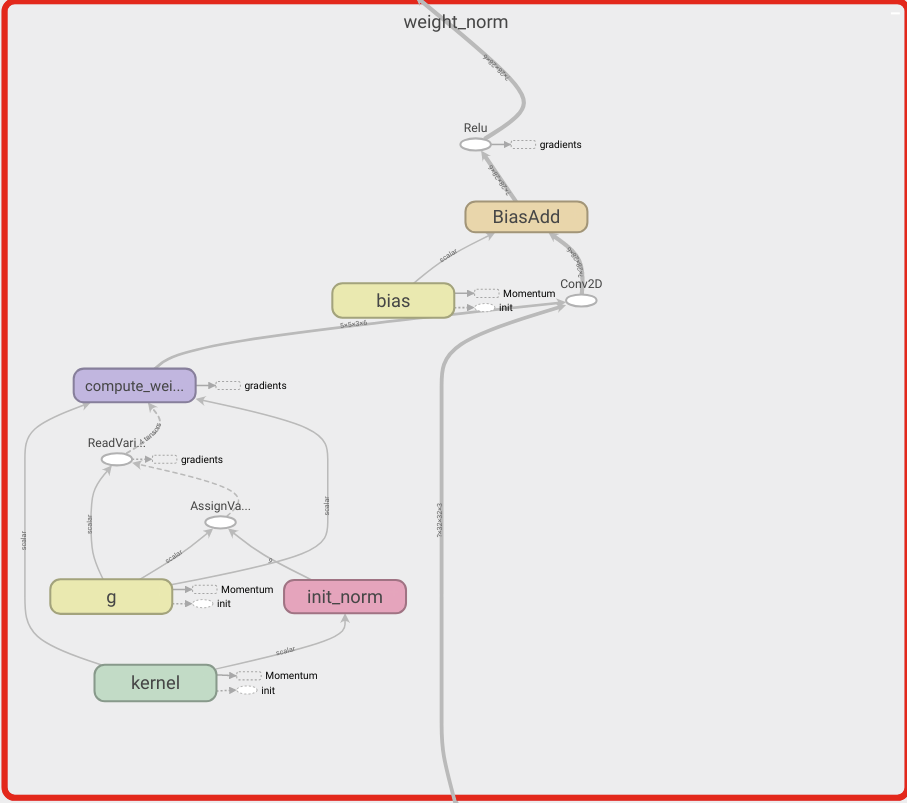

TensorFlow 애드온 레이어: WeightNormalization

개요

이 노트북은 가중치 정규화 레이어를 사용하는 방법과 수렴을 향상할 수 있는 방법을 보여줍니다.

WeightNormalization

심층 신경망의 훈련을 가속하기 위한 간단한 재매개변수화:

Tim Salimans, Diederik P. Kingma (2016)

이러한 방식으로 가중치를 재매개변수화함으로써 최적화 문제의 처리를 개선하고 확률적 경사 하강의 수렴을 가속합니다. 재매개변수화는 배치 정규화에서 영감을 얻었지만, 미니 배치의 예제 간에 종속성을 도입하지는 않습니다. 이는 이 방법이 LSTM과 같은 반복 모델과 심층 강화 학습 또는 생성 모델과 같은 노이즈에 민감한 애플리케이션에 성공적으로 적용될 수 있음을 의미합니다. 이 방법은 훨씬 간단하지만, 여전히 전체 배치 정규화의 속도를 크게 향상합니다. 또한, 이 방법의 계산 오버헤드가 더 적으므로 같은 시간에 더 많은 최적화 단계를 수행할 수 있습니다.

설정

In [ ]:

In [ ]:

In [ ]:

In [ ]:

모델 빌드하기

In [ ]:

In [ ]:

데이터 로드하기

In [ ]:

모델 훈련하기

In [ ]:

In [ ]:

In [ ]:

TensorFlow.org에서 보기

TensorFlow.org에서 보기 Google Colab에서 실행하기

Google Colab에서 실행하기 GitHub에서 소스 보기

GitHub에서 소스 보기 노트북 다운로드하기

노트북 다운로드하기