Path: blob/master/site/pt-br/addons/tutorials/layers_weightnormalization.ipynb

38411 views

Copyright 2020 The TensorFlow Authors.

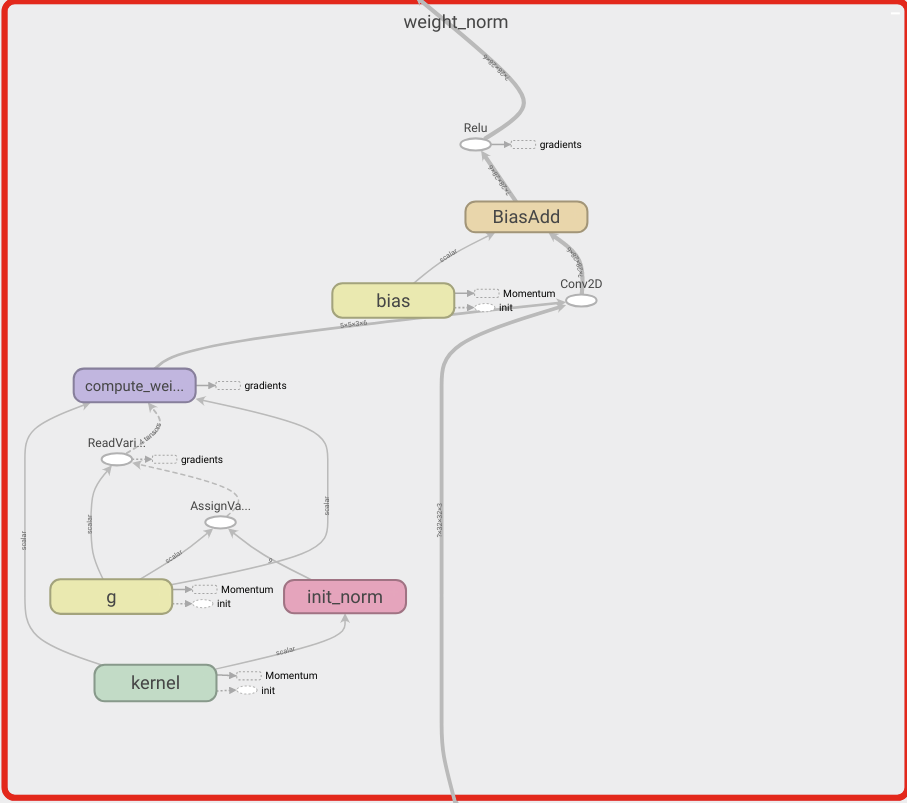

Camadas do TensorFlow Addons: WeightNormalization

Visão geral

Este notebook demonstra como usar a camada de normalização de pesos e como ela pode melhorar a convergência.

WeightNormalization

A Simple Reparameterization to Accelerate Training of Deep Neural Networks (Uma reparametrização simples para acelerar o treinamento de redes neurais profundas):

Tim Salimans, Diederik P. Kingma (2016)

Ao reparametrizar os pesos dessa forma, você melhora o condicionamento do problema de otimização e acelera a convergência do método do gradiente descendente estocástico. Nossa reparametrização é inspirada pela normalização de lote, mas não introduz quaisquer dependências entre os exemplos de um minilote. Isso significa que nosso método também pode ser aplicado com êxito a modelos recorrentes, como LSTMs, e aplicativos sensíveis a ruído, como modelos gerativos ou de aprendizado por reforço profundos, para os quais a normalização de lote é menos adequada. Embora nosso método seja muito mais simples, ele ainda fornece grande parte da aceleração que a normalização de lote completa. Além disso, a carga computacional do nosso método é mais baixa, permitindo mais passos de otimização no mesmo período de tempo.

Ver em TensorFlow.org

Ver em TensorFlow.org Executar no Google Colab

Executar no Google Colab Ver fonte no GitHub

Ver fonte no GitHub Baixar notebook

Baixar notebook