Path: blob/master/site/zh-cn/tutorials/generative/style_transfer.ipynb

38518 views

Copyright 2018 The TensorFlow Authors.

神经风格迁移

本教程使用深度学习通过其他图像的风格创造图像(您是否也曾希望自己可以像毕加索或梵高一样绘画?)。 这项技术被称为神经风格迁移,有关信息在 A Neural Algorithm of Artistic Style(Gatys 等人)中进行了概述。

注:本教程演示了原始的风格迁移算法。它将图像内容优化为特定风格。现代方式会训练模型以直接生成风格化图像(类似于 CycleGAN)。这种方式要快得多(最多可达 1000 倍)。

有关使用 TensorFlow Hub 中的预训练模型进行风格迁移的简单应用,请查看使用任意图像风格化模型的任意样式的快速风格迁移教程。有关使用 TensorFlow Lite 进行风格迁移的示例,请参阅使用 TensorFlow Lite 进行艺术风格迁移。

神经风格迁移是一种优化技术,主要用于获取两个图像(内容图像和风格参考图像(例如著名画家的艺术作品))并将它们混合在一起,以便使输出图像看起来像内容图像,但却是以风格参考图像的风格“绘制”的。

这是通过优化输出图像以匹配内容图像的内容统计和风格参考图像的风格统计来实现的。这些统计信息是使用卷积网络从图像中提取的。

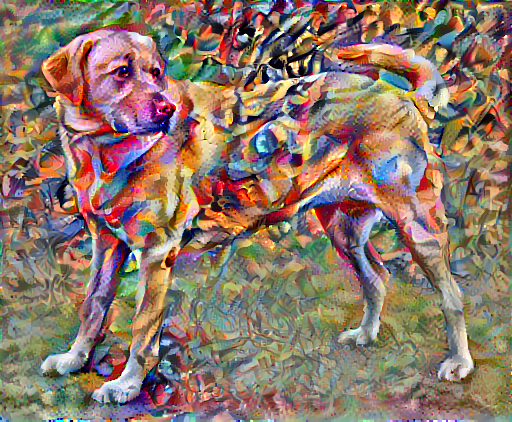

例如,让我们为这只狗和 Wassily Kandinsky 的构图 7 拍摄一张图像:

黄色拉布拉多犬,来自 Wikimedia Commons 的 Elf。许可证 CC BY-SA 3.0

现在,如果 Kandinsky 决定用这种风格专门为这只狗绘画,会是什么样子?是否会是类似这样的画作?

安装

导入和配置模块

下载图像并选择风格图像和内容图像:

呈现输入

定义一个加载图像的函数,并将其最大尺寸限制为 512 像素。

创建一个简单的函数来显示图像:

使用 TF-Hub 进行快速风格迁移

本教程演示了原始风格迁移算法,这种算法将图像内容优化为特定风格。在了解细节之前,我们先看一下 TensorFlow Hub 模型是如何做到这一点的:

定义内容和风格的表示

使用模型的中间层来获取图像的内容和风格表示。从网络的输入层开始,前几个层的激活表示边缘和纹理等低级特征。随着深入网络,最后几层代表更高级的特征 – 对象部分,如轮子或眼睛。在此教程中,我们使用的是 VGG19 网络架构,这是一个已经预训练好的图像分类网络。这些中间层是从图像中定义内容和风格的表示所必需的。对于输入图像,我们尝试匹配这些中间层的相应风格和内容目标的表示。

加载 VGG19 并在我们的图像上测试它以确保正常运行:

现在,加载没有分类部分的 VGG19 ,并列出各层的名称:

从网络中选择中间层的输出以表示图像的风格和内容:

用于表示风格和内容的中间层

那么,为什么我们预训练的图像分类网络中的这些中间层的输出允许我们定义风格和内容的表示?

从高层理解,为了使网络能够实现图像分类(该网络已被训练过),它必须理解图像。 这需要将原始图像作为输入像素并构建内部表示,这个内部表示将原始图像像素转换为对图像中存在的 feature (特征)的复杂理解。

这也是卷积神经网络能够很好地泛化的原因:它们能够捕获不变性并定义类内的特征(例如猫与狗),这些特征与背景噪声和其他滋扰无关。因此,在将原始图像输入模型和输出分类标签之间的某个位置,该模型用作复杂的特征提取程序。通过访问模型的中间层,您可以描述输入图像的内容和风格。

构建模型

tf.keras.applications 中的网络让您可以使用 Keras 函数式 API 轻松提取中间层值。

要使用函数式 API 定义模型,请指定输入和输出:

model = Model(inputs, outputs)

以下函数构建了一个 VGG19 模型,该模型返回一个中间层输出的列表:

然后建立模型:

风格计算

图像的内容由中间 feature maps (特征图)的值表示。

事实证明,图像的风格可以通过不同 feature maps (特征图)上的平均值和相关性来描述。 通过在每个位置计算 feature (特征)向量的外积,并在所有位置对该外积进行平均,可以计算出包含此信息的 Gram 矩阵。 对于特定层的 Gram 矩阵,具体计算方法如下所示:

这可以使用 tf.linalg.einsum 函数简洁地实现:

提取风格和内容

构建一个返回风格和内容张量的模型。

在图像上调用此模型,可以返回 style_layers 的 gram 矩阵(风格)和 content_layers 的内容:

运行梯度下降

使用此风格和内容提取程序,我们现在可以实现风格传输算法。我们通过计算每个图像的输出和目标的均方误差来做到这一点,然后取这些损失值的加权和。

设置风格和内容的目标值:

定义一个 tf.Variable 来表示要优化的图像。 为了快速实现这一点,使用内容图像对其进行初始化( tf.Variable 必须与内容图像的形状相同)

由于这是一个浮点图像,因此我们定义一个函数来保持像素值在 0 和 1 之间:

创建一个 optimizer。本教程推荐 LBFGS,但 Adam 也可以正常工作:

为了优化它,我们使用两个损失的加权组合来获得总损失:

使用 tf.GradientTape 来更新图像。

现在,我们运行几个步来测试一下:

运行正常,我们来执行一个更长的优化:

总变分损失

此实现只是一个基础版本,它的一个缺点是它会产生大量的高频误差。 我们可以直接通过正则化图像的高频分量来减少这些高频误差。 在风格转移中,这通常被称为总变分损失:

这显示了高频分量如何增加。

而且,本质上高频分量是一个边缘检测器。 我们可以从 Sobel 边缘检测器获得类似的输出,例如:

与此相关的正则化损失是这些值的平方和:

这展示了它的作用。但是没有必要自己去实现它,因为 TensorFlow 包括一个标准的实现:

重新进行优化

选择 total_variation_loss 的权重:

现在,将它加入 train_step 函数中:

重新初始化图像变量和优化器:

并进行优化:

最后,保存结果:

了解更多

本教程演示了原始风格迁移算法。有关风格迁移的简单应用,请查看此教程,以详细了解如何使用 TensorFlow Hub 中的任意图像风格迁移模型。

在 TensorFlow.org 上查看

在 TensorFlow.org 上查看 在 Google Colab 中运行

在 Google Colab 中运行 在 GitHub 中查看源代码

在 GitHub 中查看源代码 下载笔记本

下载笔记本 查看 TF Hub 模型

查看 TF Hub 模型